时间:2018-05-03 09:01

人气:

作者:admin

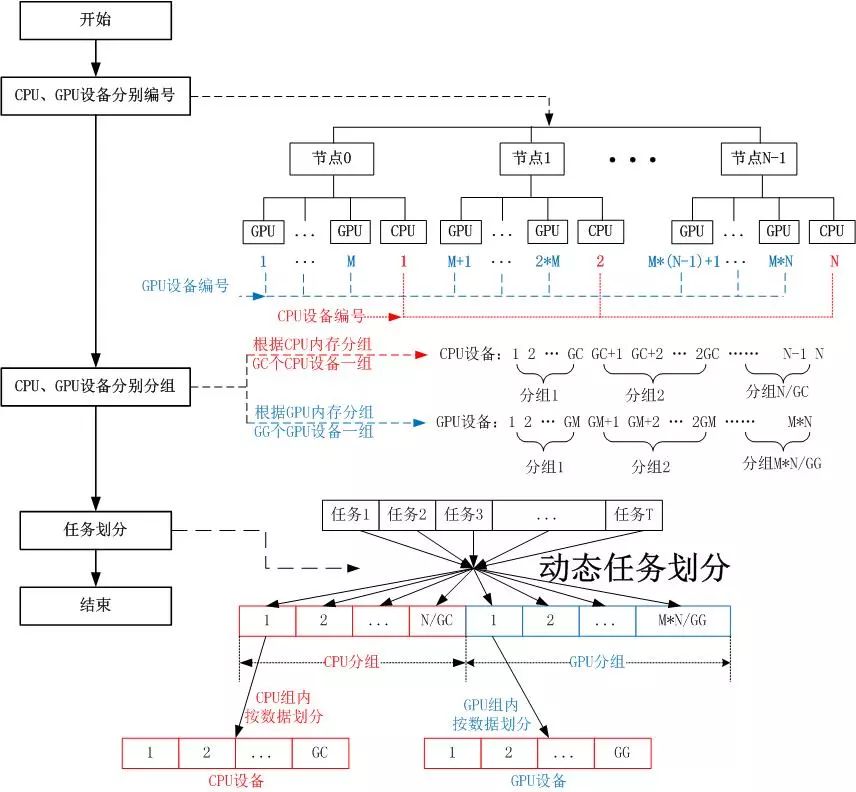

在CPU+GPU协同计算中,CPU和GPU的计算能力不同,静态地给CPU和GPU划分任务会导致CPU和GPU计算不同步,导致严重的负载不均衡,为了实现CPU和GPU的负载均衡,需要对CPU和GPU不同的划分方法。把每个节点上的所有CPU看成一个设备,每块GPU卡看成一个设备,对集群节点上的所有CPU设备和GPU设备分别编号,每个节点上有M块GPU卡,N个节点上共有N个CPU设备,编号为1,2,…,N;N个节点上共有M*N个GPU设备,编号为1,2,…,M*N。

设备编号之后就可以对设备进行分组,根据算法的要求,有些任务不能细分,一个CPU设备或GPU设备上可用的内存空间可能不能满足计算的内存要求,需要多设备数据划分、共同计算,这时需要根据CPU内存或GPU内存进行分组

1)根据CPU内存大小和计算对内存的要求可以计算得到一组内的CPU设备数目为GC个, GC=(Mcom+MemC-1)/MemC,其中一个节点的内存大小为MemC,每个计算任务需要的内存大小为Mcom。

所有的CPU设备分为N/GC个组,每个组计算同一个任务,组内的CPU设备再进行数据划分,数据划分采用静态的划分,因为组内的CPU设备计算能力一致;

2)根据GPU内存大小和计算对内存的要求可以计算得到一组内的GPU设备数目为GG个, GG=(Mcom+MemG-1)/Mem,其中,一个GPU设备的内存大小为MemG,每个计算任务需要的内存大小为Mcom。

所有的GPU设备分为M*N/GG个组,每个组计算同一个任务,组内的GPU设备再进行数据划分,数据划分采用静态划分的方法。

CPU和GPU设备分组之后,就可以把任务动态分划分给每个CPU组或GPU组,可以采用MPI通信进行划分,由主进程进行动态的发送任务编号给各个CPU组或GPU组内的组长,组长再把任务编号广播给组内的组员,然后组内的设备同时计算,计算完毕之后即可向主进程请求下一个任务,直到所有任务计算完毕为止。